2023-9-26

株式会社 東芝

世界初、精度99.9%で物体を追跡するLiDAR技術を開発

~高精度な物体の認識・追跡と、猛烈な雨・濃霧環境下で検知距離2倍以上、

計測範囲の柔軟性の向上を実現し、

空間のデジタルツインの構築であらゆる産業の効率化に貢献~

開発のポイント

・世界最高精度の99.9%で、車両や人といった物体を追跡

・LiDARの取得データのみで、世界最高精度の98.9%で物体を認識

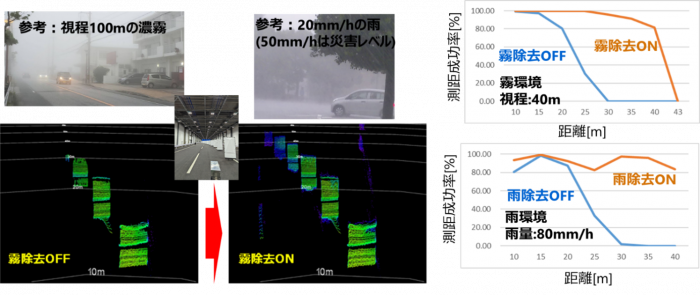

・雨・霧を除去するアルゴリズムの開発により、猛烈な雨や濃霧環境下での検知距離を2倍以上改善

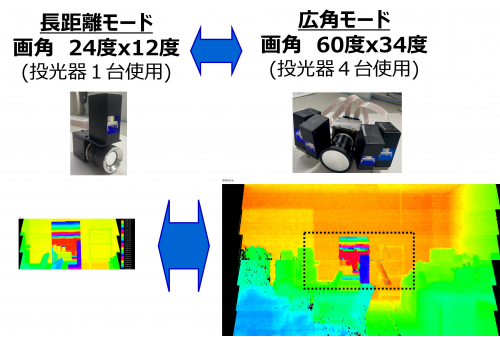

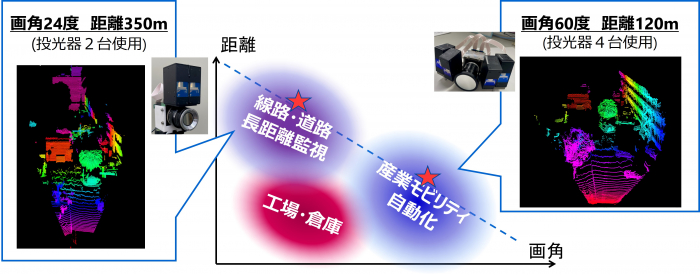

・計測範囲可変技術を開発し、従来技術に比べ計測距離を350mまで伸長、6倍の広画角化を実現

概要

当社は、自動運転や社会インフラ監視に不可欠な「目」の役割を担う距離計測技術「LiDAR」(*1)において、車両や人といった物体を、世界最高精度の99.9%(*2)で追跡する技術を開発しました。本技術は合わせて、LiDARの取得データのみで、精度98.9%での物体認識を実現するとともに、耐環境性能および計測範囲の柔軟性を大幅に高めることに成功しました。これらは全て世界初(*3)の技術となり、LiDARのポテンシャルを大幅に向上します。

近年、LiDARは自動運転としての用途に加え、カメラと併用して「空間のデジタルツイン」を構築し、空間上のあらゆるモビリティの自動化や、製造や物流ラインの全体最適化など、あらゆる産業の効率化につなげる取り組みが進められていますが、カメラとLiDARの取得データの活用において、両データの空間的・時間的なずれによる認識精度の劣化が大きな課題となっています。

当社は、LiDARのみで得られる2次元データと3次元データを高精度に融合する「2D・3DフュージョンAI」を開発し、カメラを用いず物体を世界最高精度の98.9%で認識し、99.9%で追跡することに成功しました。これにより、「空間のデジタルツイン」の構築において、従来必要だった大量のカメラの設置が不要になることも見込めます。

当社はさらに、「雨・霧除去アルゴリズム」を開発し、猛烈な雨・濃霧環境下での検知距離を2倍以上改善し、80mm/hの猛烈な雨環境で40mの距離計測ができることを確認しました。また、「計測範囲可変技術」により、従来技術に比べ計測距離を350mまで伸長しつつ、約6倍の画角で120mの計測距離を実現しました。

開発の背景

デジタルツインはシミュレーションの一種ですが、従来のシミュレーションと異なり、実世界の変化にリアルタイムに連動することが大きな特長です。例えば、機械の摩耗や破損などは、あらかじめ想定した条件のバーチャルモデルで行う従来のシミュレーションではリアルタイムに捉えることができませんでした。デジタルツインでは、センシング技術とAIを活用して実際に動いている生産ラインや設備などから膨大なデータをリアルタイムで収集することで、実世界で起こっている事象をバーチャル上に忠実に再現することができます。

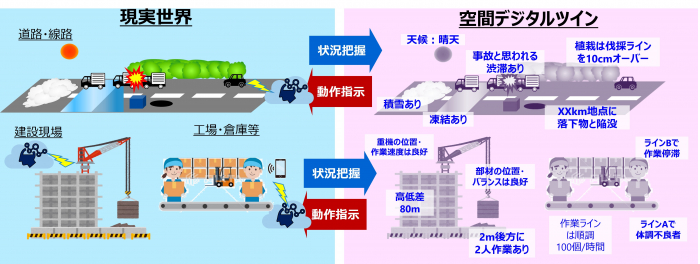

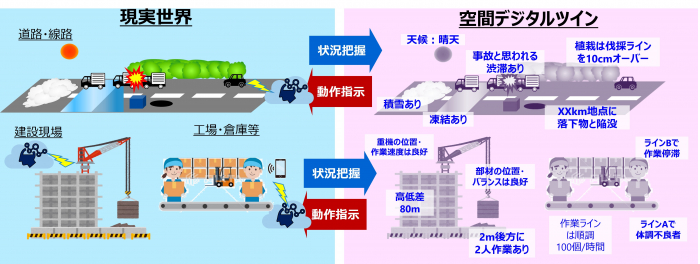

近年、このような特定の機械や製造ラインを再現する「設備のデジタルツイン」に加え、工場や都市空間全体を再現する「空間のデジタルツイン」のニーズが高まっています(図1)。「空間のデジタルツイン」を構築し、空間上の物体の動きを把握することにより、あらゆるモビリティを自動化したり、工場・物流倉庫などでは全体最適を図ったりすることができるようになります。また、都市空間では、事故や渋滞に起因するトラブルの回避につなげることができるようになります(図2)。

「空間のデジタルツイン」の構築には、夜間、雨・霧といった悪天候の環境下でも広範囲・高精度で空間をセンシングしたり、高精度に物体を認識・追跡したりする技術が不可欠です。これを実現する技術としてLiDARへの期待が高まっています。

当社はこれまで主に、LiDARの自動運転やインフラ監視での活用を想定し、計測距離伸長や小型化に取り組んできましたが(*4)、従来はLiDARの測定データのみを用いてAIで物体を高精度に認識し、それを追跡することが困難でした。物体を認識・追跡するために、カメラとLiDARを併用し、2次元データと3次元データを合わせて計測する手法がとられていますが、2種類のデータの空間的なずれを完全に排除することが難しく精度劣化の要因となっています。また、雨・霧といった悪天候の環境下で精度が劣化したり、設置場所の制限により死角が発生したりするといった課題がありました。

図1: 空間デジタルツインの活用イメージ

図2: 空間デジタルツインによるモビリティ自動化のイメージ

本技術の特長

そこで当社は、高精度な「空間のデジタルツイン」の構築に向け、カメラを用いずLiDARから取得するデータのみで物体の高精度な認識・追跡を実現する「2D・3DフュージョンAI」、LiDARの計測精度を劣化させる雨や霧による影響を最大限緩和できる「雨・霧除去アルゴリズム」、LiDARの距離と画角を設置場所に応じて自在に変更できる「計測範囲可変技術」を世界で初めて開発しました。

1.2D・3DフュージョンAI

「2D・3DフュージョンAI」はカメラを用いずLiDARの取得データのみで、物体の高精度な認識・追跡を実現します。

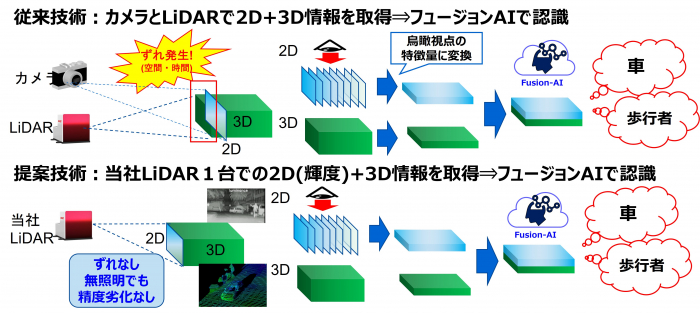

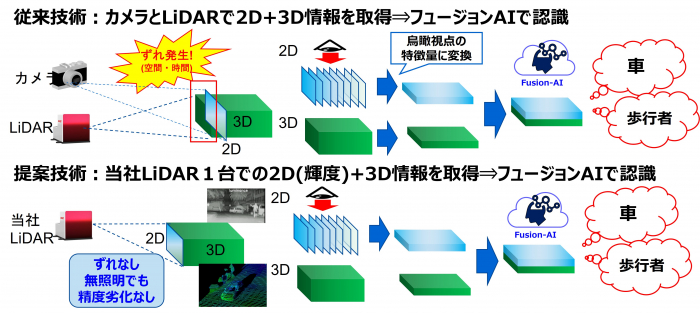

物体の認識・追跡を実現するには、カメラとLiDARによるデータを用いて学習したAIモデルが使用されていますが、AIモデルを適用するために、カメラとLiDARの画角とフレームレートを合わせ込み、空間的にも時間的にも精密に同期させる必要があります(図3上)。カメラとLiDARは物理的に設置場所にずれが生じるためずれを補正するのが一般的ですが、補正誤差が生じたり、そもそも、振動など何等かの要因で画角やフレームレートが相対的にずれたりすることがあり、認識精度が大きく劣化してしまうことが課題となっています。

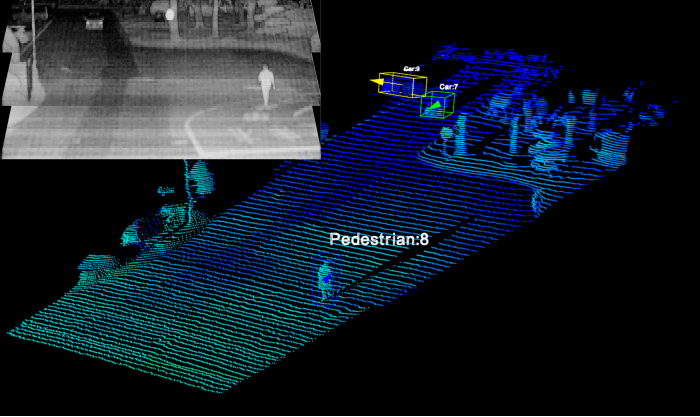

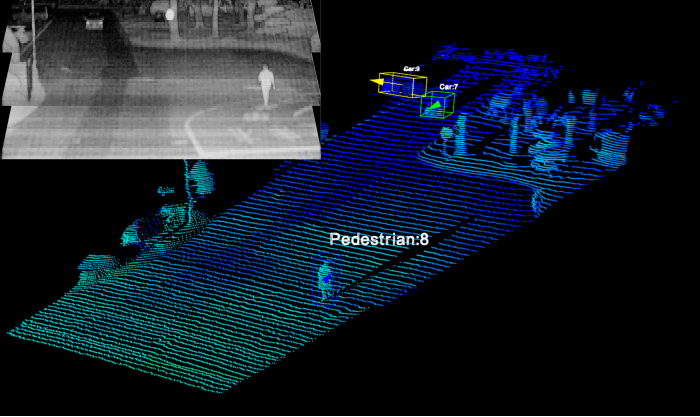

今般、当社はLiDARのみで、2次元データ(輝度)と3次元データを取得できることに着目し、LiDARで得た2次元データと3次元データを融合(フュージョン)してAIを適用・学習することで物体を認識・追跡できる「2D・3DフュージョンAI」を開発しました (図3下)。2次元データと3次元データは、LiDARの同一の画素から同一のタイミングで読み込まれたデータのため、合わせ込みが不要で認識精度が劣化する懸念がありません。本AI技術により、カメラを用いず、照明のない夜間でも、車両や人といった物体を世界最高精度の98.9%で認識し、99.9%で追跡することに成功しました(図4)。

2.雨・霧除去アルゴリズム

「雨・霧除去アルゴリズム」は、LiDARの計測精度を劣化させる雨や霧による影響を最大限緩和します。

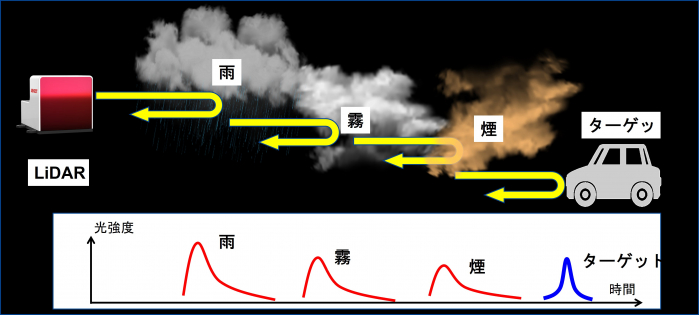

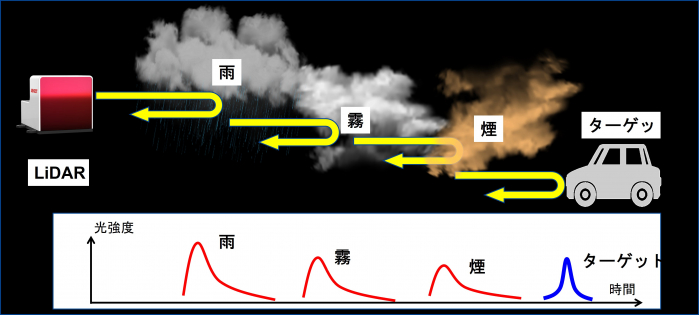

LiDARは赤外レーザーを用いますが、赤外光は水分に当たると吸収・散乱される性質があり、雨・霧・雪といった視界不良な屋外環境では計測精度が低下し、検知可能距離が短くなってしまう課題がありました。LiDARメーカー各社は雨粒を含む物体からの複数の反射光の中から、計測対象物からの反射光のみを選択するマルチエコー機能を搭載していますが、雨や霧に埋もれてしまった計測対象物からの脆弱な反射光を抽出できず、計測精度の向上に向け、さらなる研究開発が求められていました。

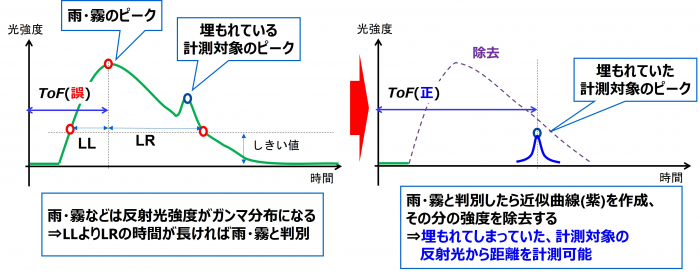

当社は、アナログデータをデジタルデータに変換するADコンバータによって、反射光強度のデジタル値を基に、水などの散乱粒子による反射光の特徴量から、雨・霧なのか、計測対象なのかを判別し、雨・霧と判断したらその波形ごと取り除くことで、雨・霧に埋もれてしまった脆弱な反射光を含めて計測対象物からの反射光を抽出するアルゴリズムを開発しました(図5)。

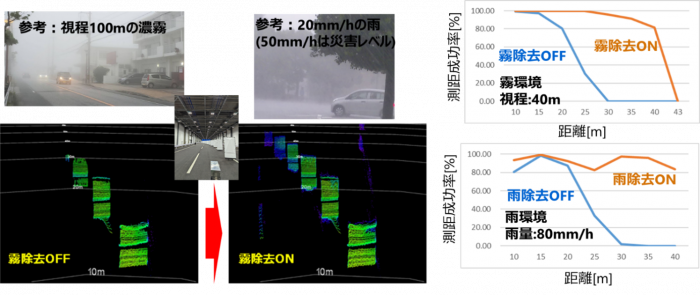

本アルゴリズムを適用したLiDARを用いて、実環境を模擬した実験設備で検知可能距離を計測したところ、80mm/hの猛烈な雨環境においては20mから40m、視程40mの霧環境においては17mから35mと、従来の2倍以上に向上することを確認しました(図6)。

3.計測範囲可変技術

「計測範囲可変技術」は、設置場所に応じて、LiDARの距離と画角によって決まる計測範囲を自在に変更することを可能にします。

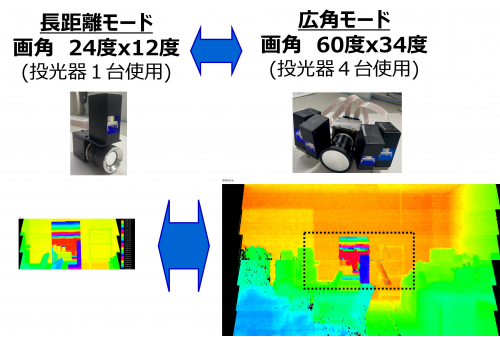

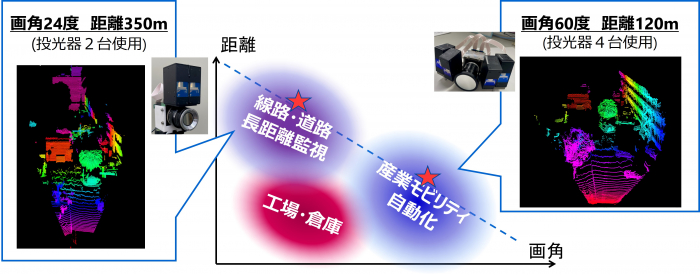

当社は昨年、71cm³まで小型化した投光器を2台用いることで、アイセーフ(*5)の基準を満たしつつ、計測距離を1.5倍にし、広角性能の向上を実現するLiDAR技術を発表しましたが(*6)、今般、この投光器の台数と受光レンズの構成を変更することで、計測距離のさらなる伸長および6倍の広画角化に成功しました。当社は、画角60度(水平H)×34度(垂直V)において世界トップクラスである120mの計測距離(図7)と画角24度(水平H)×12度(垂直V)において世界最長計測距離 (*7)である350m(図8)を達成しました。本技術により、長距離計測が求められる道路や線路などのインフラ監視に加えて、広角性能が求められる工場や倉庫内のAGV(*8)自動運転など、空間のデジタルツインでの適用を拡大できます。

これらの技術は、当社のLiDARのポテンシャルを大幅に向上することができ、LiDARを用いた空間のデジタルツインの構築に大きく貢献します。

図3: 従来(上)と今回(下)の2D・3DフュージョンAI

図4:今回開発した2D・3DフュージョンAIを用いた車両と歩行者の認識・追跡結果

(上:LiDARによる2次元データ 下:3次元データ)

図5: 今回開発したLiDAR向け雨・霧除去アルゴリズム

図6:今回開発した雨・霧除去アルゴリズムの検証結果

図7:今回開発したLiDAR向け計測範囲可変技術 広角モード実証結果

図8:今回開発したLiDAR向け計測範囲可変技術

開発した技術の適用分野と長距離モード実証結果